Blog | VFX begrippenlijst (Raymond Doetjes)

VFX zijn tegenwoordig nagenoeg in iedere film terug te zien. Maar wat doen deze VFX-mensen nu precies en wat betekenen de vaak gehoorde begrippen zoals Motion capture en CGI nu eigenlijk? Dit lees je in de onderstaande blog van Raymond Doetjes.

Bekijk ook

Wat zijn Special Effects, Visual Effects en CGI?

Ik zal beginnen met de basistermen. De gewone filmgenieter haalt ‘special effects’ en ‘visual effects’ nog weleens door elkaar. Voor een FX-artiest als mijzelf is er echter een hele duidelijke scheidingslijn! Ieder effect dat je op set, door de viewfinder van de camera ziet, valt onder special effects. Alles dat je niet door de viewfinder van de camera ziet en later wordt toegevoegd zijn visual effects. Dit betekent niet dat alle elementen (dat zijn de verschillende beelden die uiteindelijk in een shot te zien zijn), computer gegenereerd zijn. Als het computer gegeneerd is, bijvoorbeeld een 3D-render van een Transformer, dan is het een CGI (Computer Generated Imagery) element. Nu we duidelijk het verschil weten, kunnen we beginnen met enkele van de meest geziene/gehoorde begrippen, maar dit is slechts een subset!

Elementen

Als eerste moeten we het begrip ‘element’ even uitleggen, aangezien VFX altijd worden opgebouwd uit verschillenden elementen. Een element is een op zichzelf staand stukje film- of fotomateriaal dat vervolgens tijdens het compositing process (samenvoegen) bij elkaar wordt gebracht tot een beeld. Neem als voorbeeld deze scene uit de serie Game of Thrones (zie screenshot). We zien als achtergrond een brandende vlakte die waarschijnlijk gemaakt is in Photoshop. Daarnaast zien we ridders, die gefilmd zijn op een green screen stage. Ook zijn er vuur-elementen die ooit apart gefilmd zijn op een green screen (of black screen – maar daar ga ik verder niet op in). De rook-elementen zijn apart gefilmd of zijn door middel van speciale “fluid simulatie software” tot stand gekomen. Dan is er natuurlijk de draak, welke ongetwijfeld uit een 3D applicatie komt. Als laatste is er nog actrice Emilia Clarke als Daenerys, die door middel van green screen op de draak is gezet.

Rotoscoping en Mattes van oudsher

Op de aftiteling zie je vaak tientallen ‘rotoscope artists’ vermeldt staan. Wat zijn dit precies? Rotoscoping bestaat al sinds de begintijden van special effects fotografie. De Franse filmmaker Georges Méliès, merkte al snel dat wanneer hij een deel van de lens afschermde met een stukje zwart karton, hij een tweede belichting (double exposure) kon creëren. Wanneer hij vervolgens het voormalig donkere stukje belichte en het reeds belichtte deel afschermde (het masker als het waren omdraaien), kon hij een ander element filmen. Dit is te zien in bijvoorbeeld The India Rubberhead. Deze zogenaamde “mattes”, zijn nog steeds de hoeksteen voor visual effects compositing.

Deze “mattes” of maskers waren statisch. Dus bewegende mensen konden niet worden “uitgeknipt” om vervolgens over iets anders heen geplakt te worden. De zogenaamde “Travelling Matte” methode, werd ontwikkeld door Frank Williams in 1918. In dit procedé werd een blank stukje film over een reeds ontwikkelde film gelegd en vervolgens de persoon of een ander bewegend voorwerp beeldje voor beeldje met verf ingekleurd. Daar werd vervolgens een negatief van gemaakt en over de film met het voorgrond materiaal dat je wilde “uitknippen” gelegd en herbelicht. Je had dan alleen de voorgrond over met zwart er omheen. Dit kun je vervolgens weer herbelichten over een andere film waar je de voorgrond in wilde hebben. Al met al een zeer tijdrovende klus, maar deze methode was tot vrij recent nog in gebruik.

In Indiana Jones and the Temple of Doom hangt Indy bijvoorbeeld aan de kapotte brug. Hierbij leek het alsof onze held en zijn tegenstanders het risico liepen om een flinke val te maken. De rivier met de krokodillen was echter een matte painting. In werkelijkheid bevonden de acteurs zich namelijk slechts enkele meters van de grond. De diepte was een illusie door die middel van een matte painting en andere film-elementen tot stand gekomen is. Waar onze held zijn benen boven het water hangen, zijn deze beeldje voor beeldje met kwastje en inkt ge-rotoscoped; zodat deze weer zichtbaar gemaakt konden worden.

Rotoscoping digitaal

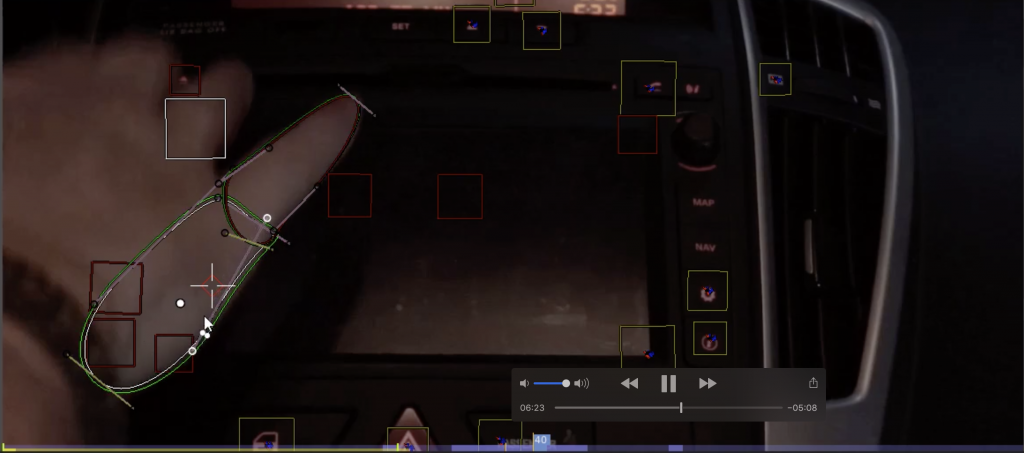

Rotoscoping is ter vergelijken met het Williams procédé, alleen in plaats van inkt en penseel worden er lijntjes getekend, zogenaamde “splines” om de voorgrond voorwerpen heen, die men wilt uitknippen. Dit heeft als voordeel dat je niet in ieder beeldje alles opnieuw hoeft te tekenen, aangezien veel van een persoon gedurende een seconde niet beweegt. Je kunt de hele “spline” makkelijk verplaatsen met zogenaamde keyframes. Dit zijn twee momenten waarin je de computer vertelt waar een spline zich bevind op tijdstip A en waar het zich bevind op tijdstip B. De computer trekt dan de kortste lijn tussen deze twee punten en beweegt automatisch de vorm tussen deze twee punten. Dit maakt bijvoorbeeld een auto die van links naar rechts rijdt met een constante snelheid eenvoudig te rotoscopen. Je omlijnt de auto in een frame waarin deze geheel zichtbaar is. Dan zet je de “spline” over de auto aan het begin van het scherm, waar de auto het beeld in komt rijden en klikt op keyframe. Vervolgens zet je een tweede keyframe aan het einde van het scherm waar de auto uitbeeld verdwijnt. Wanneer de auto dus een constante snelheid heeft, en niet varieert in hoogte, dan heb je met 1 spline en 2 keyframes een prima uitgesneden auto. Deze auto kun je vervolgens ergens anders over heen zetten. Rotoscopes worden met name gebruikt om voorgrond elementen weer over een “achtergrond element” te zetten. De volgende 3 foto’s (uit mijn compositing met Blender cursus) illustreren dit.

Het radar element staat over de vinger en breekt de illusie dat het radar beeld op het scherm staat.

We rotoscopen de vinger gedurende de tijd dat deze over het scherm beweegt.

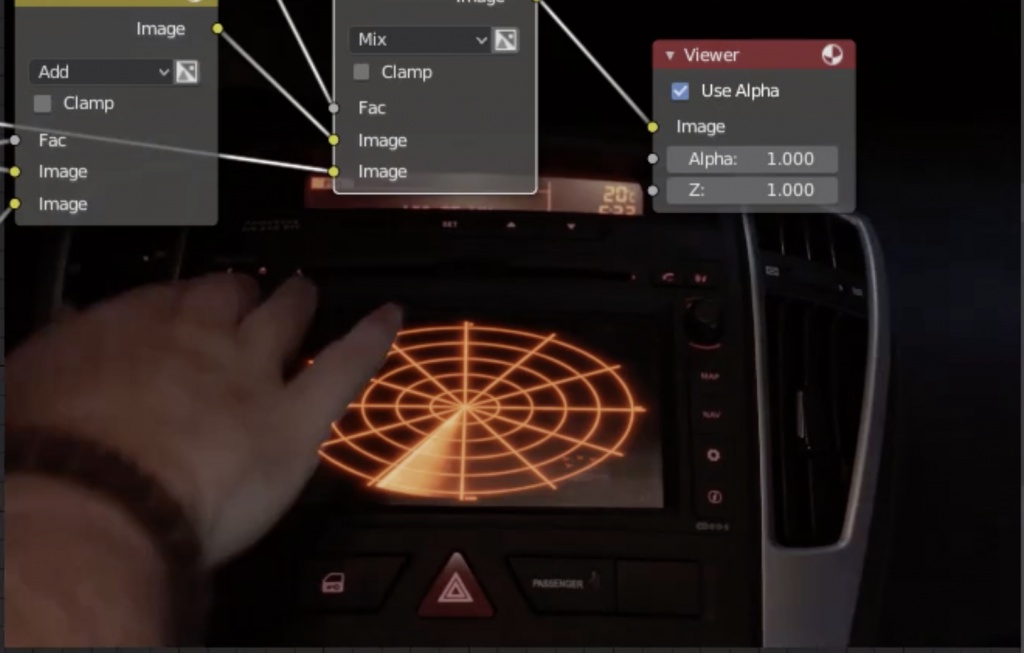

In compositing stadium, brengen we de vinger uitgesneden film, over het scherm, waardoor het lijkt alsof het radar beeld op het schermpje zit.

Resultaat van rotoscoping waardoor de hand weer over het CG radar scherm wordt gebracht. Hier wordt rotoscoping met name voor gebruikt. Ondanks de computer is rotoscoping nog steeds een enorm tijdrovende proces en wordt zoveel mogelijk ontweken.

Software dat hier o.a. voor gebruikt wordt: zie compositing pakketten.

Chromakeying

Chromakeying is in de volksmond beter bekend als green screen, een doorontwikkeling van het “Dunning Process”. Dunning kwam erachter dat hij “traveling mattes” kon maken door de voorgrond te belichten met geel licht tegen een blauwe achtergrond, en vervolgens de film te ontwikkelen met blauw filter en bepaalde gele inkt. Zo hield hij de zwart wit voorgrond over. Dit is voor het eerst toegepast in de film King Kong (1933).

Dunning process evolueerde rond de jaren 60 in het alom gebruikte “Optical Printer Process”. Dat proces is op zijn beurt weer geëvolueerd in het tegenwoordig alom bekende greenscreen keying proces. Maar waarom gebruikt men nu groen en vroeger blauw? Men gebruikt groene schermen met name wanneer er met digitale camera’s gefilmd wordt. Aangezien digitale sensoren twee keer zoveel groene pixels hebben dan rode of blauwe. De zeer vereenvoudigde reden is dat onze ogen met name meer gevoelig zijn voor licht (luminance) dan voor kleur en groen draagt met name de lichte tinten. Onze hersenen kunnen redelijk goed kleur voorstellen als er maar genoeg licht is. Dus deze dubbele resolutie maakt het voor de computer ‘makkelijker’ om het groen te herkennen. Men kan ook gewoon met rood, paars of blauw “keyen”, of met wit (een zogenaamde lumance key). Het nadeel van met name blauw is dat blauw niet erg intens is qua kleur en op een digitale sensor dus erg veel ruis bevat. Een bijkomend voordeel is dat “chromakey groen” een kleur is die in de natuur niet voorkomt. Wanneer men vandaag de dag een “blue screen” ziet, kan men met 99% zeker zijn dat men op “ouderwetse” film schiet, omdat film met name erg gevoelig is voor blauw.

Maar hoe werkt het ‘chroma key’en nu eigenlijk?

Wat we eigenlijk willen bereiken is dat we een alfa kanaal maken. Iedereen die wel eens met een een tekenprogramma heeft gewerkt, is bekend met transparante plaatjes. De transparantie komt uit het alfakanaal en dit is eigenlijk een soort ‘instructie’ voor de computer. Wat het alfakanaal van een plaatje namelijk tegen de computer zegt is, “alles dat zwart is in mijn alfakanaal daarvan moet je de kleurenwaardes van de laag eronder (de achtergrond) tekenen. Alles dat wit is in mijn alfakanaal, daarvan moet je de kleurenwaardes tekenen”.

Als je dat weet dan is het een relatief eenvoudig mathematisch probleem en dus uitermate geschikt voor een computer om heel snel te kunnen uitvoeren. Een simpel algoritme is het zogenaamde ‘channel difference keyer’ algoritme.

alfa = 1-( groen – max(rood, blauw) )

Wat doen we in deze formule?

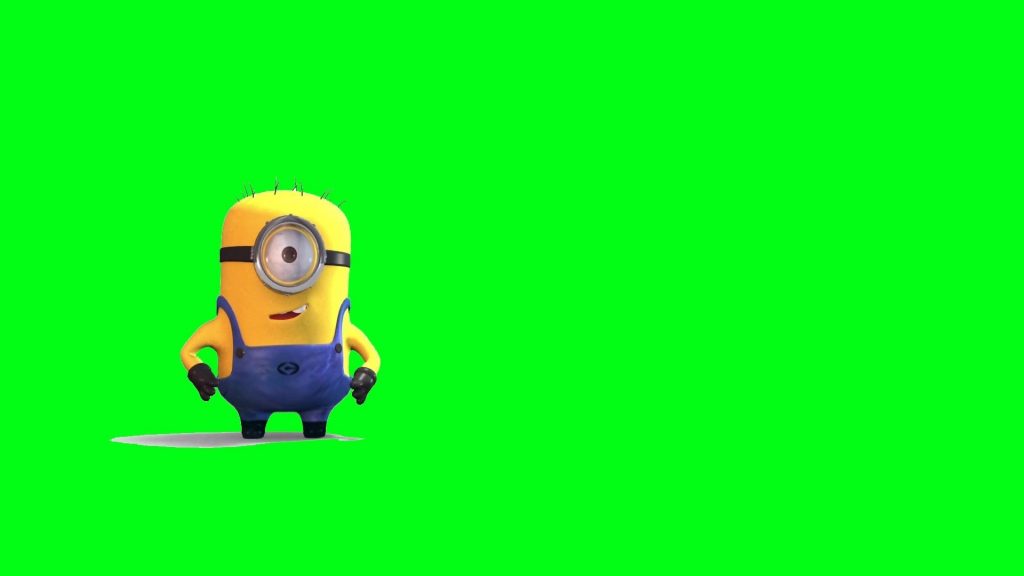

We zoeken uit welk kanaal de grootste waarde heeft en die waarde wordt vertaalt in een waarde tussen 0 en 1 ten opzichte van elkaar; waarbij 0 overwegend groen is en 1 overwegend rood of blauw is. Laten we het geheel eens uitproberen op de onderstaande Minion, die op een green screen staat.

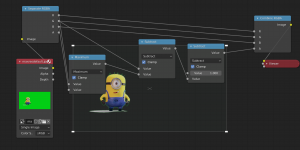

Hieronder heb ik het algoritme in Blender compositor de formule opgebouwd met zogenaamde nodes; compositors doen eigenlijk alleen maar aan visueel programmeren.

- Voor iedere pixel splitst ik de kleur op in een rood, groen en blauw waarde, deze waardes liggen tussen 0 en 1.

- Ik neem de hoogste waarde van de rode of de blauwe pixel (we willen het verschil weten, tussen de hoogste rode of blauwe waarde ten opzichte van de groen waarde).

- Vervolgens wordt de waarde van de groene pixel van de maximale waarde van rood of blauw afgetrokken en dan weet je het verschil tussen groen en rood/blauw.

- Nu moet ik alleen dat resultaat omdraaien, ook wel “inverteren” genoemd; omdat in een alfakanaal zwart immers transparant is en wit zichtbaar is, dit doe je door 1 van het getal af te trekken (omdat alle waardes tussen 0 en 1 liggen).

- Vervolgens voeren we deze waardes in het alfakanaal… en voilà, de achtergrond is verdwenen.

Geavanceerde Keyer software, laten je meer doen met de matte en het bron-bestand, maar in essentie gebruiken alle “channel difference keyers” het bovenstaande algoritme in de basis.

Het chroma-key procedé reduceert dus de behoefte voor het meer inefficiënte rotoscopen. Daarnaast is er echter een probleem met chroma-key, het zogeheete “greenspil”. Greenscreens worden belicht (soms zelfs van achteren) en dit groene licht valt over de voorgrond heen. Mensen zien er dan erg ziekelijk uit. Dus wat je dan moet doen is deze beelden weer “dispillen”, kortom de groene tint vervangen voor een andere tint. De Visual Effects Supervisor van The Dark Knight was hier zo bang voor met alle zwarte glimmende voorwerpen, dat hij had besloten om geen green/blue screen te gebruiken maar alles te rotoscopen. Veelal bestaat green screen niet uit “het trekken van 1 key”, maar worden er meerdere keys gecombineerd tot een “traveling mask”, vaak ook nog gecombineerd met rotoscoping.

Software that hiervoor gebruikt wordt zijn o.a: plugins van compositing pakketten, zoals: IBK Keyer, Keylight, Ultimatte, Primatte

2D MATTE PAINTING

Zelf ben ik begonnen met 2D matte painting, wat ook weleens oneerbiedig “photoshoppen” wordt genoemd. Dit wordt tegenwoordig met name gebruikt voor de achtergrond. Omdat een foto geen diepte heeft valt dit het minste op in een achtergrond. Hieronder zie je een matte painting die ik gemaakt heb voor een Aziatische Tour Operator in 2014 en dit zou ergens in China moeten zijn. De bereisde onder ons herkennen de brug in deze foto misschien als de Stenenbrug van de Japanse tuinen in Singapore.

Het voordeel van matte painting is dat het heel snel in orde gemaakt kan worden. Waar men bij 3D een heleboel verschillende stappen moet doorlopen, zoals modelleren, UV-unwrapping, texturing en lighting, is het in 2D een stuk eenvoudiger. Alleen lichtval moet je faken, perspectief moet je enorm veel rekening mee houden en het matchen van levels (licht en donker) en kleur is iets waar de painter zich wel druk om moet maken. Je ziet dat tegenwoordig dat 2D steeds vaker wordt gebruikt in de concept-fase en dat men voor de productie zelf steeds meer in 3D gaat doen. 2D zal echter altijd een vast onderdeel blijven in een VFX pipeline.

Software: Photoshop, Affinity Photo

Set extensions/Environments

Met een set extension wordt bedoelt dat je de set uitbreidt met een stukje CGI. Dit kan zowel 2D en/of 3D zijn. In veel scenes is tegenwoordig alleen de voorgrond echt en de rest van de omgeving (environment) computer gegenereerd. Hierdoor kunnen producers flink wat geld besparen, aangezien er geen enorme sound stages (studio’s) gehuurd hoeven te worden.

Ik heb hieronder twee shots van een Indie film geplaatst waarvoor ik destijds de set extensions verzorgd heb. Normaliter zou ik het shot in 3D hebben gedaan, echter was het VFX-budget voor deze film zo enorm klein dat mocht ik überhaupt nog winst willen maken, ik wel op 2D aangewezen was. Je ziet hier ook goed de stappen van het matte painting in terug komen.

Software dat hier o.a. voor gebruikt is: Photoshop, Affinity Photo, Compositing pakketen, 3D pakket.

3D

3D is een onderwerp op zichzelf en iets waar ik ooit een aparte blog aan zal wijden. 3D in het kort komt neer om iets in speciale 3D software (zoals Blender of Maya) te ontwerpen. Dit te voorzien van textures en dat wordt eventueel geanimeerd en gerenderd.

Werken met 3D is redelijk tijdrovend, zeker als je er hele environments mee wilt maken, zoals in het voorbeeld hierboven. Het voordeel van 3D is echter wel dat je het slechts 1 keer hoeft te maken en vervolgens kunt hergebruiken. Omdat in de afgelopen 20-25 jaar zoveel gemodelleerd is, wordt dit steeds vaker hergebruikt. Hierdoor wordt er steeds meer gebruik van 3D gemaakt. Als je bijvoorbeeld snel even een olievat nodig hebt, is het vaak het makkelijkst om deze snel even uit een bibliotheek te importeren en in je 3D scene te zetten. Alle belichting en perspectief occlusie krijg je er gratis bij. Het voordeel van 3D is ook dat de virtuele camera het object van iedere kant kan bekijken. Dit terwijl je met 2D natuurlijk maar beperkte bewegingsruimte hebt.

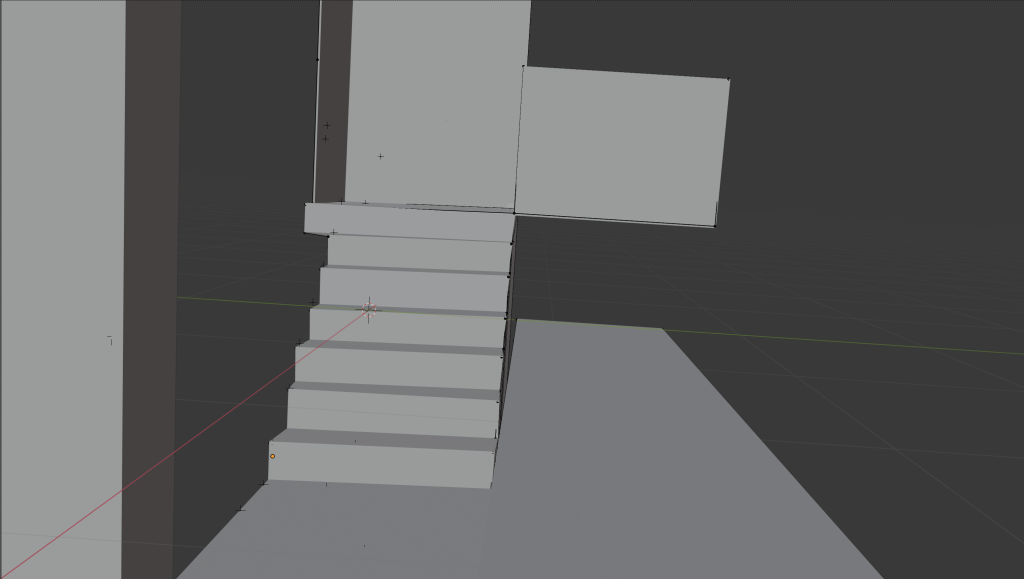

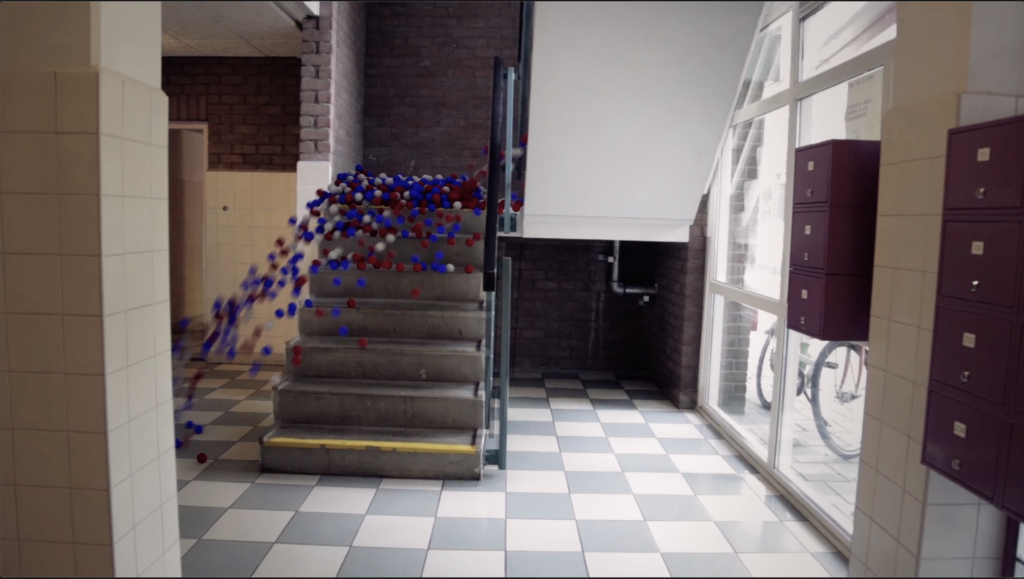

3D wordt ook gebruikt om zogenaamde ‘proxies’ te maken van de echte sets zodat “physics” effecten hiermee kunnen interacteren. Denk aan duizenden CG ballen die van een trap afkomen, CG water dat door een gang of een straat stroomt of rook dat opstijgt in een gebouw. Om dit te realiseren wordt hetgeen dat je op de live action plate ziet in hele abstracte vorm nagemaakt in 3D.

In onderstaand voorbeeld zie je dat de CGI ballen interactie hebben met een CGI replica van de omgeving van de echte ‘set’. Zodra je alleen de ballen rendered en deze vervolgens in de set plaatst, lijkt het net alsof de ballen van de trap afstromen.

Software die o.a. gebruikt wordt: Maya (defacto standard), 3DS Max, Houdini, Z-Brush, Modo, LightWave en de gratis (in Nederland ontstane) Blender wordt steeds meer gebruikt

Motion capture

Motion capture is het opnemen van de bewegingen van een acteur. Deze bewegingen worden dan aan een zogenaamd “IK RIG” (een sit van virtuele botten in 3D) gekoppeld. Op deze manier kunnen deze IK BONES (IK botten) dan op hun beurt weer een 3D model laten bewegen. Dit werd voor het eerst op grote schaal gebruikt voor Gollum in The Lord of the Rings en later uiteraard voor Avatar. Waar er voorheen een speciale soundstage nodig was, kan men tegenwoordig met speciale kostuums, waar op iedere bewegend stuk van het lichaam een zogenaamde accelerometer zit, overal de bewegingen van een acteur opslaan. Het gebruiken van deze techniek is de afgelopen jaren steeds voordeliger geworden, waardoor het nu ook soms toegankelijk is voor de onafhankelijke filmmaker.

Voorbeelden van Motion capture software zijn o.a: Blender (met de XBOX Kinect voor), Rokoko die ook een kostuum maakt, Motionbuilder

VFX Supervisor

De VFX supervisor zie je tegenwoordig vrijwel direct na de regisseur verschijnen in de credits. Maar wat doet zo’n persoon nu eigenlijk? Er zijn twee type VFX supervisors. Je hebt de VFX supervisor die bedenkt hoe een VFX shot gemaakt moet gaan, deze stuurt dan ook de leads van de 2D, 3D, tracking teams aan en controleert de kwaliteit alvorens hij deze shots aan de art director laat zien. Deze persoon berekend ook wat een shot gaat kosten zodat de studio voor wie hij werkt een bod kan uitbrengen.

Je hebt daarnaast de Onset VFX supervisor. Vroeger was dat veelal dezelfde persoon als de algemene VFX supervisor, al wordt daar tegenwoordig vaak speciaal iemand voor ingehuurd. De Onset VFX supervisor is de persoon die tijdens de opnames de regie heeft over de mensen om de opname binnen budget te houden. Dit is een heel exact beroep. Je noteert bijvoorbeeld de camera setting en registreert waar alle lampen staan. Daarnaast meet je de afstanden tussen belangrijke zaken onset, zoals van de camera tot de positie waar een CGI-element geplaatst moet gaan worden. Wij worden door regisseurs en producers gehaat tijdens de productie, omdat ons werk relatief veel tijd in beslag neemt. Tevens worden we geliefd door diezelfde producers en regisseurs omdat geen enkel shot precies zo gaat als tijdens pre-productie geplande wordt en wij snel ter plaatse oplossingen kunnen en moeten bedenken. De meest bekende, en waarschijnlijk de allerbeste en allereerste VFX supervisor is Dennis Murren van het bedrijf Industrial Light & Magic (ILM). Een man die zowel Special Effects als Visual Effects begrijpt!

Technical Director

Met name de grotere studio’s maken hun eigen software in house om efficiency te verhogen, of aan een unieke vraag van een producent te kunnen voldoen. Veel van de software die nu verkrijgbaar is, is zo ontstaan. Dit zijn met name mensen met een achtergrond in wiskunde, natuurkunde en computer wetenschap — of seniors die doorgegroeid zijn. Hun taak is het oplossen van technische problemen.

Een studio die bestaansrecht wilt hebben en meerwaarde voor de grote Hollywood-films, zullen inzetten op het ontwikkelen van eigen software en zo een niche creëren. ILM is er immers de grootste door geworden. Soms kan 6 maanden software ontwikkeling tot een uniek shot leiden dat een film waarde geeft, dat met de huidige off the shelf tools niet mogelijk is. Denk bijvoorbeeld aan het ‘vouwen’ van de stad in Inception en de bullettime uit The Matrix; dit is allemaal custom made software dat een unieke ervaring voor de kijker gaf. Voor de producenten betekende dit veel “betalende kontjes in de cinema stoelen!” en “DVD verzamelaars!”

Wil je gegarandeerd in de VFX-business werkzaam zijn en je hebt een exact brein? Studeer dan wiskunde, natuurkunde en/of computer wetenschap (gericht op computer graphics) en dan zijn er absoluut banen voor je!

Programmeer talen: C/C++, Python, MEL en wordt bekend met de Qt en OpenCV libraries

Matchmover (motion tracking)

Matchmover is een beetje mijn specialiteit geworden. Ik heb ooit in een grijs verleden (tijdens mijn stage) voor een telescoop die de zon bestudeerd een 2D tracker geprogrammeerd die de zonnevlek iedere keer op dezelfde plaats in beeld hield. Hierdoor werd onderzoek makkelijker. Niet wetende dat die kennis uit 1994, mij ooit nog eens aan een Hollywood feature wist te verbinden. Hierbij maakte ik een soortgelijk algoritme, dat de beweging van water extrapoleert zodat er brandende olie en andere voorwerpen op het water gezet konden worden en zo met het water mee kon deinen.

Wat een matchmover doet, is de beweging van de camera on set omzetten in dezelfde beweging in de computer. Wij maken onderscheid tussen een 2D track en een 3D track. Bij een 2D track geef je in de tracking software aan welke punten je wilt laten volgen, en deze heeft geeft dan alleen de X en Y locatie terug van dat punt voor ieder frame; in sommige gevallen ook de ‘scale’ zodat je CG-elementen ook kan laten vergroten en verkleinen als deze dichter of verder van de camera bewegen. Voor veel toepassingen is een 2D track voldoende (zoals je hieronder ziet met de kattenoogjes).

Meer interessant is een 3D track. Hier geeft de matchmover aan welke punten er gevolgd moeten worden door de software (de software kan deze punten ook in hoge mate zelf kiezen maar is niet zo goed als een persoon). Vervolgens wordt aan de hand van complexe wiskunde (die snap ik ook maar gedeeltelijk; daar hebben we wiskundige voor) deze data vertaald naar een camera in de 3D wereld. Dit wiskundige proces heet photogrammetry. Het berust op het feit dat de punten op de voorgrond sneller bewegen dan de punten in de achtergrond. Hier kan je dan een “triangulation” (driehoek vergelijking) op los laten en zo bepalen waar de camera had moeten staan om al deze punten zo in verhouding te krijgen. Mochten de wiskundige onder jullie meet willen weten dan verwijs ik je door naar de lezing Photogrammetry II.

Maar wat doet men met deze data? Vraag je je vast af. We gebruiken deze data om elementen (2D voor 2D tracks en 3D tracks voor 3D elementen) mee te laten bewegen met de camera. Als je dat niet zou doen, dan beweegt de camera, maar blijft je element precies daar staan waar het was en breekt deze de illusie. Dit is vergelijkbaar met een titel over een bewegend beeld, waarbij de titel stil blijft staan, terwijl het beeld eronder gewoon links, rechts, naar boven of naar onder beweegt.

Voordat we digitaal konden werken, moesten we gebruik maken van statische shots (dit noemen we een locked off shot). ILM bracht daar met Star Wars verandering in, door een robot te maken die heel exact de beweging kon herhalen tot op 100 micrometer nauwkeurig, om ze deze shots vervolgens in de “Optical Printer” te combineren. Hierdoor kon de camera mee bewegen met de actie en dit was met name wat Star Wars zo bijzonder maakte voor die tijd. Een leuk feitje is dat de machine nauwkeuriger was dan de optical printers die gebruikt werd om de verschillende elementen te filmen. Deze machine was genaamd de Dykstra machine, na de uitvinder John Dykstra die voor ILM werkte — hetgeen eigenlijk een robot arm was waar een camera op gemonteerd stond.

Nu met hele krachtige computers en digitale verwerking van het beeldmateriaal, kunnen we dus zelfs 3D tracken, maar dat is niet altijd even eenvoudig. Een verkeerde track en camera solve kan leiden tot “slippage” (het glijden van een element) dat direct de illusie verbreekt. Ervaring in de software helpt meestal deze problemen op te lossen. Om je een idee te geven heb ik hier een slechte 3D track gedaan en een CG spijker er op gezet. Hier en daar mist een gerenderd frame. Mijn excuses hiervoor, maar die kon ik niet terug krijgen want ik had mijn schroef-model niet meer. Die twee rode flitsen moet je maar voor lief nemen 😉 . Hieronder zie je eerst een slechte automatische track.

Hier een correcte track met wat snelle compositing waardoor het geheel minder CG lijkt; en dit kan in een professionele setting veel netter. Het geeft echter wel een idee wat tracking en compositing doet.

Tracking software pakketen zijn o.a.: Blender, SynthEyes, Fusion, Nuke compositor, Boujou, PFTrack, Mocha

Compositor

De compositor zit een beetje aan het eind van de VFX pijplijn. Dit is iets dat ik zelf het leukste vind; hier komt namelijk kunst en techniek echt samen. Wat een compositor doet is hij neemt alle elementen (dit kunnen er tegenwoordig wel ruim honderd zijn) en combineert deze tot een volledig beeld. Je vraagt je misschien af waarom er zoveel elementen zijn? Dat is met name het geval bij 3D renders. Bij 3D renders willen wij compositors ieder onderdeel, wij noemen dat een pass, apart krijgen. Dus je hebt een pass met alleen de kleur, je hebt een pass met alleen de schaduw, je hebt een pass met het directe licht, je hebt een pass met indirecte licht, je hebt een reflectie pass een subsurface scattering pass (dat is bijvoorbeeld wanneer licht achter je oren schijnt, dat je oren een beetje roder lijken). Al deze passes moeten we samenvoegen. Het voordeel van alle passes is dat we de ultieme controle hebben over onder andere de levels (licht en donker) en de kleur zodat we de CG-elementen zo goed mogelijk aan de “plate” (de film) kunnen matchen en zo alles zo goed mogelijk integreren. Heel vaak is de schaduw zwart in een render, terwijl deze op de live plate, een tint heeft (schaduw is nooit zwart of grijs; er zit meestal wat blauw in). De reflectie is misschien soms iets te fel in vergelijk met de reflecties op auto’s in de life plate en zo kunnen we deze zoveel mogelijk hetzelfde maken. Dat is sneller dan in 3D.

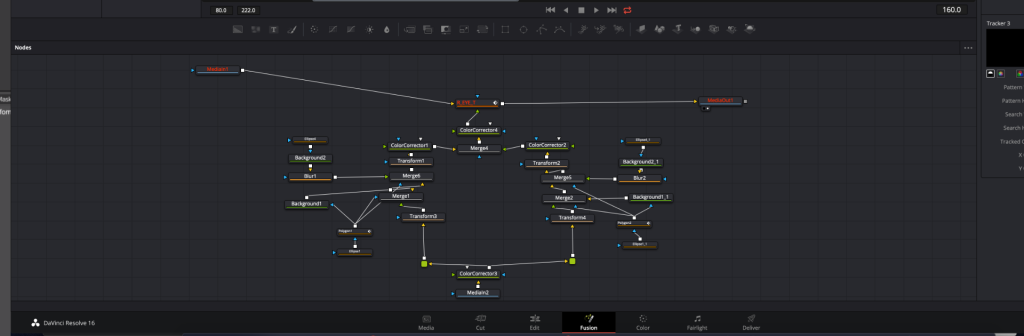

Hieronder is een eenvoudig composite die ik gedaan heb voor een tutorial die ik gaf in compositing met Davinci Resolve/Fusion voor een groepje filmstudenten. Ik heb mijzelf 2 kattenoogjes gegeven. Alles hier is 2D, dus extreem eenvoudig.

Maar je ziet al snel dat de “node graph” complex wordt. Deze node graph is het “compositen”, wat eigenlijk hetzelfde is als programmeren maar dan met nodes. Iedere node is een functie, en deze functies koppel je aan elkaar. Veel van deze operaties die een node, op een beeld uitvoeren, zijn dan ook eenvoudige wiskundige operaties. Naast het integreren van element ruimen compositors ook de trackers op van handen en gezichten. We halen veelvuldig ook microfoons weg die per ongeluk in beeld verschijnen als ook troep van de crew dat in beeld is blijven liggen.

In onderstaand voorbeeld werd ik op het laatste moment gevraagd om de pallets weg te halen. Hier was niets voor gepland en het overgebleven budget was genoeg voor nog ongeveer 2 uur werk. De compositor moet dan meestal met de oplossing komen. In een film zijn er net als roto-artists een heleboel compositors nodig. Een goede composite kost veel tijd, helaas krijgt men tegenwoordig steeds minder tijd en zie je dat elementen vaak niet erg goed zijn geïntegreerd.

Compositing software pakketen zijn o.a: Nuke (defacto standaard), After Effects, Fusion, Smoke en Blender en de gratis Natron (clone van Nuke zonder 3D)

COLORIST

Men kan twisten of color correction en color grading tot VFX behoren of niet. Ik persoonlijk vind het een integraal onderdeel. Vooral de overall-grade kan helpen om de CG elementen verder te integreren. Daarnaast vind ik het ook erg knap wat een goede colorist doet. Het is makkelijk (zoals je hieronder in de voorbeelden ziet) om extreme grades te maken. Maar subtiele grades die een toon zetten, is echt kunst- en vakwerk.

Een colorist doet twee dingen:

- Color correction: hier wordt gezorgd dat de shots van een scene allemaal dezelfde levels (donker/licht verhouding hebben) en allemaal dezelfde hoeveelheid saturatie (hoeveelheid kleur).

- Grade: hier wordt de ‘look’ van een scene bepaald door de schaduw, midtonen en highlights een bepaalde tint te geven. Dit helpt de toon en emotie te zetten. Net zoals een muziek componist een mineur gebruikt voor een trieste toon of een majeur voor een blijde toon, kan de colorist een diepe contrast geven met blauw of groene highlights en dat geeft direct een bepaalde gevoel aan het shot.

Hieronder zie je een filmpje dat de beelden direct uit de camera laat zien, vervolgens een color corrected beeld en dan twee enorme overdreven grades om te demonstreren wat men met grading kan doen.

Software die gebruikt wordt voor grading is o.a.: DaVinci Resolve (dekfacto standaard), FilmConvert, en Colorista.